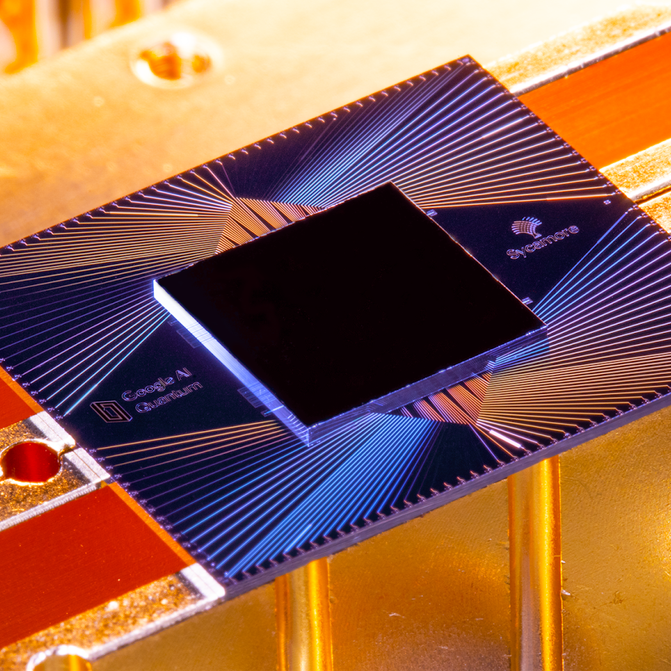

昨年10月下旬、Google は、Sycamore というチップの 1 つが、古典的マシンでは事実上不可能なタスクを実行し、「量子最高性能」を初めて実証したことを発表しました。 グーグルによれば、既存の世界最強のスーパーコンピューター「サミット」が1万年かかる計算を、わずか53個の量子ビットでシカモアは数分で完了させたという。 Google は、これをスプートニクの打ち上げやライト兄弟の初飛行になぞらえて、今日の最強のコンピューターがそろばんに見えるような、新しい時代のマシンの入り口になる大躍進だと宣伝しました。

サンタバーバラの研究所で行われた記者会見で、Googleチームは3時間近く記者からの質問に明るく答えました。 その 2 日前、量子コンピューティングにおける Google の主要なライバルである IBM の研究者が、その重大な発表を台無しにしたのです。 IBMの研究者たちは、基本的にグーグルの計算が間違っていると非難する論文を発表していたのだ。 IBMは、Sycamoreが行ったことを再現するには、数千年ではなく、数日しかかからなかっただろうと考えている。 IBMの結果をどう思うか、という質問に対して、Googleチームの責任者であるHartmut Neven氏は、明らかに直接的な答えを避けた。

あなたはこれを単なる学会の喧嘩として片付けることができるでしょうし、ある意味そうなのです。 IBM が正しかったとしても、Sycamore は Summit よりも 1,000 倍も速く計算を行いました。

しかし、IBM の深い異議は、Google の実験が主張よりも成功しなかったことではなく、そもそも意味のないテストであったということでした。

量子コンピューティングの世界の大部分とは異なり、IBM は、「量子の優位性」がライト兄弟のような瞬間だとは考えておらず、実際、そのような瞬間があるとも思っていません。 これは単なる言葉や科学の違いではなく、IBM の歴史、文化、および野心に根ざした哲学的な姿勢であり、おそらく、Google とその親会社 Alphabet が数字を伸ばし続ける一方で、8 年間にわたり同社の収益と利益がほぼ絶え間なく減少しているという事実も関係しているのでしょう。

隔世の感

ニューヨーク市北部の郊外にある IBM の Thomas J. Watson Research Center は、フィンランドの建築家 Eero Saarinen による新未来主義の傑作で、Google チームのなんでもない建物とは大陸や宇宙のような違いがあり、なめらかな曲線が特徴です。

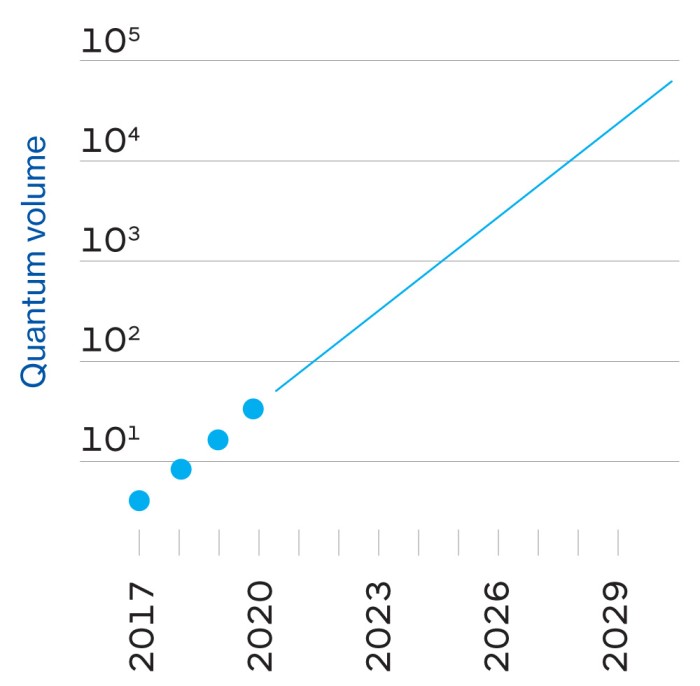

4,000人規模の研究部門のトップはスペイン人のDario Gil氏で、その早口の言葉はほとんど福音的な熱意についていくのに必死です。 私が彼と話したとき、彼は、IBM が量子コンピューター関連の研究にどれほど長い間関わってきたかを強調するために、歴史的なマイルストーンを並べ立てました (右の時間軸を参照)。

A Grand experiment: 量子理論と実践

量子コンピューターの基本的な構成要素は、量子ビット (クォビット) です。 古典的なコンピュータでは、ビットは 0 か 1 のいずれかを格納できますが、量子ビットは 0 か 1 だけでなく、重ね合わせと呼ばれる中間の状態も格納でき、さまざまな値を仮定することが可能です。 例えば、情報を色に例えると、古典的なビットは黒か白のどちらかである。

結局のところ、量子ビットは、ビットと比較して膨大な量の情報を保存および処理することができ、量子ビットを互いに接続すると、その容量は指数関数的に増大するのです。 Google の Sycamore チップ上の 53 個の量子ビットにすべての情報を格納するには、従来のコンピューターのメモリで 72 ペタバイト (720 億ギガバイト) を必要とします。 地球サイズの古典的コンピューターが必要になるまでには、これ以上の量子ビットは必要ないのです。

しかし、それは簡単なことではありません。

しかし、簡単ではありません。繊細で乱れやすい量子ビットは、熱、振動、浮遊原子からほぼ完全に隔離する必要があり、Google の量子研究所の「シャンデリア」冷蔵庫はそのためです。

また、量子コンピュータが常に古典的なものよりも高速であるとは限りません。

また、量子コンピュータが古典コンピュータより常に速いわけではありません。

この実験のために、Google は「ランダム量子回路サンプリング」と呼ばれるベンチマーク テストを選択しました。 これは、何百万もの乱数を生成しますが、量子アルゴリズムの特徴であるわずかな統計的バイアスがかかっています。

Googleは、自社の巨大サーバー ファームと、オークリッジ国立研究所の世界最大のスーパーコンピューターであるSummitで、この一部をシミュレートしました。 研究者は、Sycamore が 200 秒で完了した作業を、Summit では約 10,000 年かかったと見積もっています。

では、IBM はどのような反論をしたのでしょうか。 基本的には、古典的なコンピューターで量子マシンをシミュレートする方法はさまざまで、作成するソフトウェア、データの切り分けや保存方法、使用するハードウェアのすべてが、シミュレーションの実行速度に大きな違いをもたらすということです。 IBM によると、Google はシミュレーションを多くのチャンクに分割する必要があると想定していましたが、280 ペタバイトのストレージを持つ Summit は、Sycamore の完全な状態を一度に保持できるほどの大きさだそうです。 (そして、IBM は Summit を構築したので、それを知っているはずです。)

しかし、数十年にわたって、同社は研究プロジェクトを商業的成功に導くのに苦労しているという評判を得てきました。 直近では、IBM がロボットの医療指導者に変えようとした、ジョパディをプレイする AI、Watson がそうです。

量子コンピューティング チームは、研究とビジネス開発を並行して行うことにより、このサイクルを断ち切ろうとしていると Gil は言います。

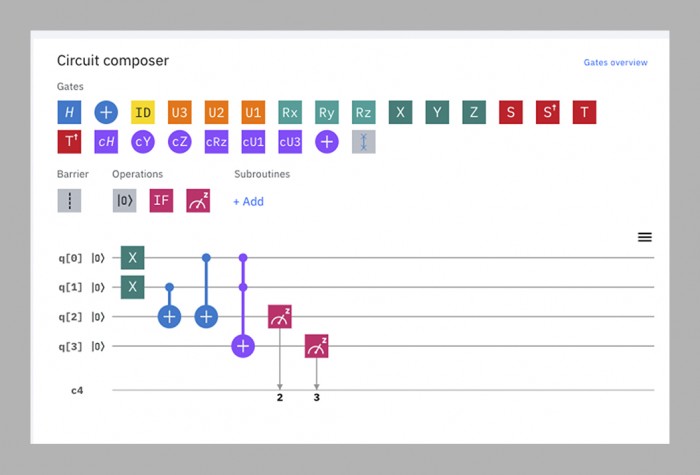

ギル氏によれば、量子コンピューティング チームは、研究とビジネス開発を並行して行うことにより、このサイクルを断ち切ろうとしています。 2016年に開始された「IBM Q Experience」は、現在、5~53量子ビットの大きさの、公開されている15の量子コンピューターで構成されています。 学術研究者から小学生まで、月に約1万2,000人が利用している。

これらのデバイス、あるいは Google の Sycamore を除く世界中の量子コンピュータのどれもが、何事においても古典的なマシンに勝てるということをまだ示していません。

これらのデバイス、あるいは Google の Sycamore を除く世界の他の量子コンピュータは、まだ古典的なマシンに勝てることを示したわけではありません。 マシンをオンラインで公開することで、IBMは将来の顧客がマシンに何を求めているかを知り、外部のソフトウェア開発者がマシンのためのコードの書き方を学ぶことができるのです。

このサイクルこそが、いわゆる量子アドバンテージへの最短ルートだと、IBM は考えています。

これが、ギル氏の IBM の大統一理論です。遺産、技術的専門知識、他者の頭脳、およびビジネス顧客に対する献身を組み合わせることにより、誰よりも早く、誰よりも優れた有用な量子コンピューターを構築できるのです。

このような観点から、IBM は Google の量子最高性能のデモンストレーションを「パーラー トリック」と見ています、と Google が使用している量子アルゴリズムに貢献したテキサス大学オースティン校の物理学者である Scott Aaronson 氏は述べています。 よく言えば、行わなければならない本当の仕事から目をそらすための派手な演出です。 最悪の場合、量子コンピューターが、ある狭い分野ではなく、どんな分野でも古典的なコンピューターに勝てる、と思わせてしまう可能性があるからだ。 「

もちろん、Google は、これとは異なる見方をしています。

新興企業の登場

Googleは、2006年に初めて量子問題をいじり始めたとき、8歳の早熟な会社でしたが、専門の量子研究所を設立したのは2012年になってからでした。「

研究室の代表は、ドイツ人のコンピューター科学者であるハルトムート・ネヴェン(Hartmut Neven)氏。 (当初、ネーヴェンは外部のD-Wave社が作ったマシンを購入し、しばらくはそれで量子力学に挑戦していたが、うまくいかなかったという。 彼は、2014年にグーグルの当時のCEOであるラリー・ペイジに、グーグルがプレスキルの挑戦に挑むと約束して、量子コンピュータの構築に投資するよう説得したと言います。「私たちは彼に、『ラリー、聞いてくれ、3年後に戻って来て、少なくとも古典的マシンの能力を超える問題を計算できる試作チップを君のテーブルに置く』と言った」

IBMの量子専門知識がなかったグーグルは、カリフォルニア大学サンタバーバラにいる物理学者のジョン・マーティネスが指揮するチームを外部から雇用したのです。 マーティニスと彼のグループは、すでに世界最高の量子コンピュータメーカーであり、最大9個の量子ビットをつなぎ合わせることに成功していたため、ネヴェンのペイジへの約束は、彼らが目指すべき立派な目標に思えたのです。

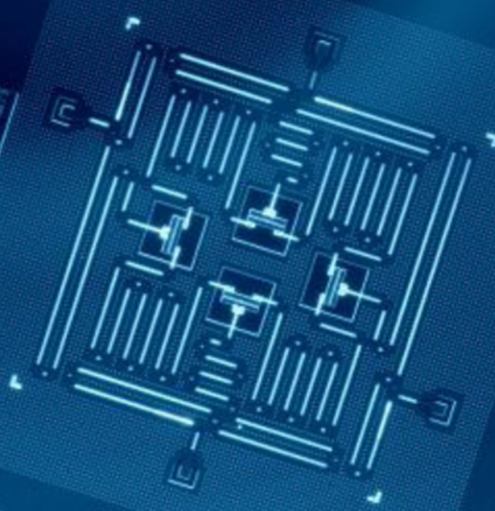

3 年の期限が到来し、マーティーニスのチームは挑戦に対して十分に大きく、十分に安定しているチップを作ろうと苦闘してきました。 2018年、Googleはこれまでで最大のプロセッサであるBristleconeをリリースしました。 72量子ビットを持つこのプロセッサは、ライバルが作ったものを大きく引き離しており、マルティニスは同年中に量子的な覇権を獲得すると予測した。 しかし、チームメンバーの何人かは、Sycamoreと呼ばれる別のチップアーキテクチャの研究を並行して行っていた。 そのため、昨年秋に最高性能を実証したのは53量子ビットのチップであった。

実用的な目的では、そのデモで使用されたプログラムは、乱数を生成するもので、量子コンピュータが必要とするものではありません。

IBMの研究者にこの成果をどう思うか尋ねると、苦々しい表情を浮かべることでしょう。 IBMの量子チームを率いる、慎重な口調のオーストラリア人、ジェイ・ガンベッタは、「私はこの言葉も、その意味合いも好きではありません」と言います。

私が IBM の社外で話を聞いた誰もが、量子の優位性を重要視しないのは、頭が悪いとしか言いようがないと言っています。 「商業的に適切な製品を提供する人は誰でも、最初に最高であることを示さなければならないのです。 それが基本的な論理だと思う」とネーヴンは言う。 温厚な MIT の物理学者で、この論争を最も公平に観察している一人である Will Oliver でさえ、「量子コンピューターが、それが何であれ、あるタスクにおいて古典的コンピューターを上回ることを示すのは、非常に重要なマイルストーンです」と述べています。 そのようなマシンが、新薬や材料の発見に役立つ複雑な分子のモデル化、渋滞を緩和するためのリアルタイムでの都市交通の流れの最適化、より長期の天気予報など、今は実現不可能な量の総当り計算能力を必要とする問題を、いつの日か解決できるようになることが期待されているのです。 (最終的には、通信や金融取引の安全性を確保するために現在使われている暗号を解読できるようになるかもしれないが、その頃には世界のほとんどが量子抵抗暗号を採用しているだろう)。 問題は、最初の有用なタスクが何であるか、それを実行するためにどの程度のコンピュータが必要になるかを予測することは、ほとんど不可能であるということである。

その不確実性は、ハードウェアとソフトウェアの両方に関係しています。 ハードウェア面では、Google は、現在のチップ設計で、100 ~ 1,000 クビット程度まで到達できると考えています。 しかし、自動車の性能がエンジンの大きさだけに依存しないように、量子コンピューターの性能は、単純に量子ビットの数によって決定されるわけではありません。 量子ビットがどのくらい長く減衰しないか、どのくらいエラーを起こしやすいか、どのくらい速く動作するか、どのように相互接続するかなど、考慮しなければならない要素がたくさんある。 つまり、現在稼働している量子コンピュータは、その潜在能力のほんの一部にしか到達していないのです。

一方、量子コンピュータ用のソフトウェアも、マシンそのものと同様に未完成です。 古典的なコンピュータでは、プログラミング言語は、初期のソフトウェア開発者が使わなければならなかった生の「マシンコード」から数レベル離れたものである。 「古典的なコンピューターでは、プログラムを組むときに、トランジスタがどのように機能するかを知る必要はありません」と、グーグルチームのソフトウェア開発を率いるデイブ・ベーコンは言う。 一方、量子力学のコードは、量子ビットの気まぐれな性能を最大限に引き出すために、実行する量子ビットに合わせて高度に調整する必要がある。 つまり、IBM社のチップ用のコードは他社のチップでは動作しませんし、Google社の53量子ビットのSycamoreを最適化する技術も、将来の100量子ビットの兄弟機では必ずしもうまく動作しないのです。

誰もがあえて期待しているのは、数百の量子ビットを持つコンピューターが、今後数年以内に、適度に複雑な化学のシミュレーションを行うことです。 しかし、デコヒーレンスやエラーによって、暗号解読のような難しいことをする前に、これらの機械はすべて停止してしまうだろう。

1,000 qubits のパワーを持つ量子コンピューターを構築するには、100 万個の実際の量子ビットが必要です。

そのためには、「耐故障性」量子コンピューターが必要です。これは、古典コンピューターと同様に、エラーを補正して、無限に稼働させることができるコンピューターです。 期待されるソリューションは、冗長性を作り出すことです。 そうすれば、個々の量子ビットの誤差を一括して補正することができる。

一般的な予測では、この安定性を達成するには、結合した量子ビットが 1,000 個も必要です。 Googleは「控えめに」10年以内に100万量子ビットのプロセッサを構築できると見積もっているとNeven氏は言いますが、克服すべき大きな技術的ハードルがあり、その1つはIBMがGoogleに対してまだ優位に立っているかもしれません(反対ページをご覧ください)。

その時までには、多くのことが変わっているかもしれません。 Google と IBM が現在使用している超伝導量子ビットは、その時代の真空管であり、より安定で信頼性の高いものに置き換わっていることが証明されるかもしれません。 世界中の研究者が、量子ビットを作るためのさまざまな方法を試していますが、実用的なコンピュータを作るのに十分なほど高度なものはほとんどありません。 Rigetti、IonQ、または Quantum Circuits のようなライバルの新興企業が、特定の技術で優位に立ち、大企業を追い抜くかもしれません。

2つのトランスモンの物語

GoogleとIBMのトランスモン量子ビットはほとんど同じですが、1つの小さいが決定的な違いがあります。

Google と IBM の量子コンピュータでは、量子ビット自体はマイクロ波パルスによって制御されます。 この問題を解決するには、パルスの周波数を変えて、それぞれの量子ビットのスイートスポットを見つけるか、あるいは磁界を使ってそれぞれの量子ビットを正しい周波数に「調整」する方法がある。

IBMは最初の方法を、Googleは2番目の方法を使用しています。 それぞれのアプローチにはプラスとマイナスがあります。 Google の調整可能な量子ビットは、より速く、より正確に動作しますが、安定性に欠け、より多くの回路を必要とします。

技術的な観点からは、少なくとも現段階では、ほぼ一騎打ちと言えます。

技術的な観点からは、少なくとも現段階では、この差はほとんどないと言えますが、企業理念の観点からは、Google と IBM の違いを一言で言えば、つまり量子ビットで言えば、この差になります。

グーグルは軽快であることを選びました。

グーグルは軽快であることを選んだ。「一般的に、我々の哲学は、人々が通常求める数字を犠牲にして、より高い制御性を目指す」とハルトムート・ネヴェンは言う。

一方、IBM は信頼性を選択しました。 「実験室で実験して論文を発表するのと、98%の信頼性で常時稼働できるシステムを構築するのとでは、大きな違いがあります」と、Dario Gil は言います。

現在、Google が優位にたっています。 しかし、マシンが大きくなるにつれて、優位性は IBM に移るかもしれません。 各クビットは個別のワイヤで制御され、調整可能なクビットには 1 本のワイヤが追加されます。 何千、何百万もの量子ビットの配線を考えることは、両社が直面する最も困難な技術的課題の1つでしょう。IBMは、それが固定周波数の量子ビットを採用した理由の1つであると述べています。 Googleチームの責任者であるマルティニス氏は、個人的に過去3年間、配線の解決策を見出すために費やしてきたという。 「

しかし、その規模と富を考えると、Google と IBM の両社は、量子コンピューティング ビジネスで本格的なプレーヤーになる可能性があります。 企業は、現在 Amazon、Google、IBM、Microsoft からクラウドベースのデータ ストレージや処理能力を借りているように、そのマシンを借りて問題に取り組むことになるでしょう。 そして、物理学者とコンピューター科学者の戦いとして始まったものは、ビジネスサービス部門とマーケティング部門の戦いへと発展していくだろう。

このコンテストに勝つために最も適した企業はどこなのでしょうか。 収益が減少している IBM は、Google よりも切迫感があるかもしれません。 昨年の夏、過去最も高額な買い物として、オープンソースのクラウドサービスプロバイダーである Red Hat に340億ドルを支払い、この分野で Amazon と Microsoft に追いつき、財務状況を逆転させようと試みました。 同社の量子マシンをクラウド上に置き、最初から有料ビジネスを構築するという戦略は、先手を打つためのものだと思われる。

Googleは最近、IBMの例に倣い始め、その商業顧客には現在、米国エネルギー省、フォルクスワーゲン、ダイムラーなどが含まれています。 もっと早くそうしなかった理由は簡単だと、マーティニスは言います。 “クラウドに乗せるリソースがなかったから “です。

この決定が IBM に優位性をもたらしたかどうかを判断するのは時期尚早ですが、おそらくより重要なのは、今後数年間、両社の他の強みをこの問題にどう適用するかということでしょう。 IBM は、材料科学やチップ製造から大企業クライアントへのサービスまで、「フルスタック」の専門知識から利益を得ることができると Gil は言います。 一方、グーグルは、シリコンバレーのような革新的な文化を持ち、事業を急速に拡大させることに長けている。

量子至上主義そのものについては、歴史上重要な瞬間となりますが、決定的なものになるとは言いきれません。 After all, everyone knows about the Wright brothers’ first flight, but can anybody remember what they did afterwards?

Sign inSubscribe now