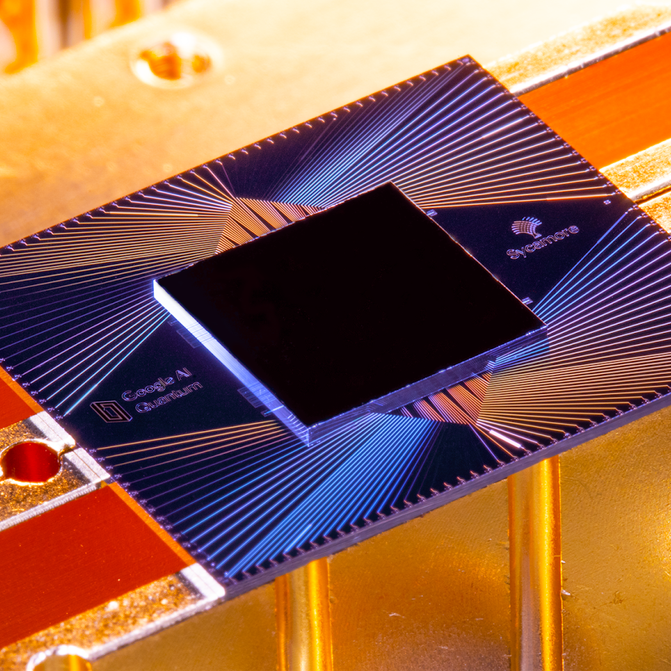

A finales de octubre pasado, Google anunció que uno de esos chips, llamado Sycamore, se había convertido en el primero en demostrar la «supremacía cuántica» al realizar una tarea que sería prácticamente imposible en una máquina clásica. Con sólo 53 qubits, Sycamore completó en pocos minutos un cálculo que, según Google, habría llevado 10.000 años al superordenador más potente del mundo, Summit. Google lo calificó de gran avance, comparándolo con el lanzamiento del Sputnik o el primer vuelo de los hermanos Wright: el umbral de una nueva era de máquinas que haría que el ordenador más potente de hoy pareciera un ábaco.

En una conferencia de prensa en el laboratorio de Santa Bárbara, el equipo de Google respondió alegremente a las preguntas de los periodistas durante casi tres horas. Pero su buen humor no pudo ocultar del todo una tensión subyacente. Dos días antes, los investigadores de IBM, principal rival de Google en el campo de la computación cuántica, habían echado por tierra su gran revelación. Habían publicado un artículo en el que acusaban a los Googlers de haber hecho mal las cuentas. IBM consideraba que Summit habría tardado sólo días, no milenios, en replicar lo que Sycamore había hecho. Cuando se le preguntó qué pensaba del resultado de IBM, Hartmut Neven, el jefe del equipo de Google, evitó directamente dar una respuesta.

Podrías descartar esto como una simple disputa académica, y en cierto sentido lo fue. Aunque IBM tuviera razón, Sycamore había hecho el cálculo mil veces más rápido que Summit. Y probablemente sólo pasarían meses antes de que Google construyera una máquina cuántica un poco más grande que demostrara el punto sin lugar a dudas.

La objeción más profunda de IBM, sin embargo, no era que el experimento de Google fuera menos exitoso de lo que se decía, sino que era una prueba sin sentido en primer lugar. A diferencia de la mayor parte del mundo de la computación cuántica, IBM no cree que la «supremacía cuántica» sea el momento de los hermanos Wright de la tecnología; de hecho, ni siquiera cree que vaya a existir tal momento.

IBM persigue, en cambio, una medida de éxito muy diferente, algo que denomina «ventaja cuántica». No se trata de una mera diferencia de palabras o incluso de ciencia, sino de una postura filosófica que tiene sus raíces en la historia, la cultura y las ambiciones de IBM y, tal vez, en el hecho de que durante ocho años sus ingresos y beneficios han estado en un declive casi incesante, mientras que Google y su empresa matriz, Alphabet, solo han visto crecer sus cifras. Este contexto, y estos diferentes objetivos, podrían influir en quién -si es que alguno de los dos- sale adelante en la carrera de la computación cuántica.

Mundos aparte

La elegante y amplia curva del Centro de Investigación Thomas J. Watson de IBM en los suburbios al norte de la ciudad de Nueva York, una obra maestra neofuturista del arquitecto finlandés Eero Saarinen, está a un continente y un universo de distancia de las anodinas excavaciones del equipo de Google. Terminado en 1961 con la bonanza que IBM hizo de los mainframes, tiene una calidad de museo, un recordatorio para todos los que trabajan en su interior de los avances de la compañía en todo, desde la geometría fractal a los superconductores a la inteligencia artificial y la computación cuántica.

El jefe de la división de investigación de 4.000 personas es Darío Gil, un español cuyo discurso rápido corre para mantenerse al día con su celo casi evangélico. Las dos veces que hablé con él, desgranó los hitos históricos que pretenden subrayar el tiempo que lleva IBM en la investigación relacionada con la computación cuántica (véase la línea de tiempo a la derecha).

Un gran experimento: Teoría y práctica cuántica

El componente básico de un ordenador cuántico es el bit cuántico, o qubit. En un ordenador clásico, un bit puede almacenar un 0 o un 1. Un qubit puede almacenar no sólo un 0 o un 1, sino también un estado intermedio llamado superposición, que puede asumir muchos valores diferentes. Una analogía es que si la información fuera un color, un bit clásico podría ser blanco o negro. Un qubit, cuando está en superposición, podría ser de cualquier color del espectro y también podría variar su brillo.

El resultado es que un qubit puede almacenar y procesar una gran cantidad de información en comparación con un bit, y su capacidad aumenta exponencialmente a medida que se conectan qubits entre sí. Para almacenar toda la información de los 53 qubits del chip Sycamore de Google se necesitarían unos 72 petabytes (72.000 millones de gigabytes) de memoria informática clásica. No hacen falta muchos más qubits para necesitar un ordenador clásico del tamaño del planeta.

Pero no es sencillo. Los qubits, que son delicados y se alteran con facilidad, deben estar casi perfectamente aislados del calor, las vibraciones y los átomos extraviados; de ahí los frigoríficos «chandelier» del laboratorio cuántico de Google. Incluso así, pueden funcionar como máximo durante unos cientos de microsegundos antes de «descohesionarse» y perder su superposición.

Y los ordenadores cuánticos no siempre son más rápidos que los clásicos. Simplemente son diferentes, más rápidos en algunas cosas y más lentos en otras, y requieren diferentes tipos de software. Para comparar su rendimiento, hay que escribir un programa clásico que simule aproximadamente el cuántico.

Para su experimento, Google eligió una prueba de referencia llamada «muestreo aleatorio de circuitos cuánticos». Genera millones de números aleatorios, pero con ligeros sesgos estadísticos que son una característica del algoritmo cuántico. Si Sycamore fuera una calculadora de bolsillo, equivaldría a pulsar botones al azar y comprobar que la pantalla muestra los resultados esperados.

Google simuló partes de esto en sus propias granjas de servidores masivos, así como en Summit, el mayor superordenador del mundo, en el Laboratorio Nacional de Oak Ridge. Los investigadores calcularon que completar todo el trabajo, que le llevó a Sycamore 200 segundos, le habría llevado a Summit aproximadamente 10.000 años. Voilà: la supremacía cuántica.

¿Y cuál fue la objeción de IBM? Básicamente, que hay diferentes maneras de conseguir que un ordenador clásico simule una máquina cuántica, y que el software que se escribe, la forma en que se cortan los datos y se almacenan, y el hardware que se utiliza marcan una gran diferencia en la rapidez con la que se puede ejecutar la simulación. IBM dijo que Google suponía que la simulación tendría que dividirse en muchos trozos, pero Summit, con 280 petabytes de almacenamiento, es lo suficientemente grande como para contener el estado completo de Sycamore a la vez. (E IBM construyó Summit, así que debería saberlo).

Pero a lo largo de las décadas, la empresa se ha ganado la reputación de luchar por convertir sus proyectos de investigación en éxitos comerciales. Por ejemplo, recientemente, Watson, la IA que juega a Jeopardy y que IBM intentó convertir en un robot gurú de la medicina. Estaba destinado a proporcionar diagnósticos e identificar tendencias en océanos de datos médicos, pero a pesar de las docenas de asociaciones con proveedores de atención médica, ha habido pocas aplicaciones comerciales, e incluso las que surgieron han dado resultados mixtos.

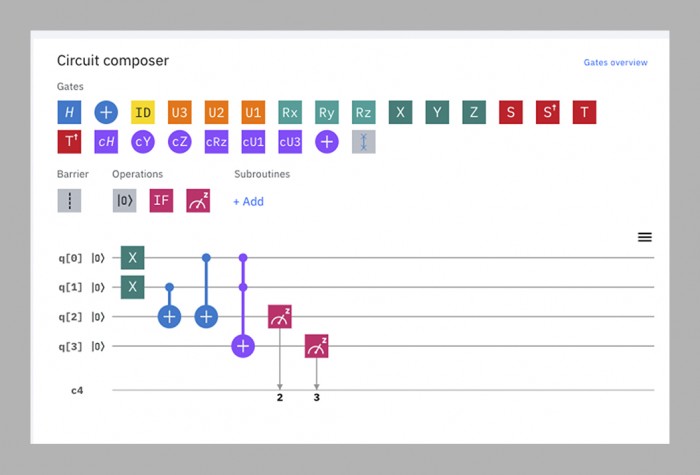

El equipo de computación cuántica, en palabras de Gil, está tratando de romper ese ciclo haciendo la investigación y el desarrollo de negocios en paralelo. Casi tan pronto como tuvo ordenadores cuánticos en funcionamiento, empezó a hacerlos accesibles a personas ajenas a la empresa poniéndolos en la nube, donde se pueden programar mediante una sencilla interfaz de arrastrar y soltar que funciona en un navegador web. La «Experiencia Q de IBM», lanzada en 2016, consta ahora de 15 ordenadores cuánticos disponibles públicamente que van de cinco a 53 qubits de tamaño. Las utilizan unas 12.000 personas al mes, desde investigadores académicos hasta niños en edad escolar. El tiempo en las máquinas más pequeñas es gratuito; IBM dice que ya tiene más de 100 clientes que pagan (no dice cuánto) para usar las más grandes.

Ninguno de estos dispositivos -o cualquier otro ordenador cuántico del mundo, excepto el Sycamore de Google- ha demostrado aún que puede vencer a una máquina clásica en cualquier cosa. Para IBM, eso no es lo importante ahora. Hacer que las máquinas estén disponibles en línea permite a la empresa aprender lo que los futuros clientes podrían necesitar de ellas y permite a los desarrolladores de software externos aprender a escribir código para ellas. Esto, a su vez, contribuye a su desarrollo, haciendo que los siguientes ordenadores cuánticos sean mejores.

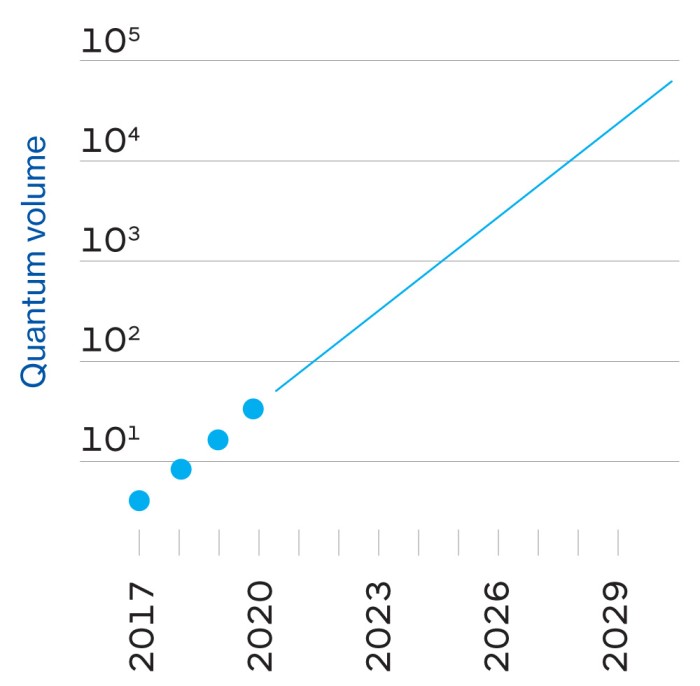

Este ciclo, según la empresa, es el camino más rápido hacia su llamada ventaja cuántica, un futuro en el que los ordenadores cuánticos no dejarán necesariamente atrás a los clásicos, sino que harán algunas cosas útiles algo más rápido o más eficientemente, lo suficiente como para que merezcan la pena económicamente. Mientras que la supremacía cuántica es un hito único, la ventaja cuántica es un «continuo», dicen los de IBM, un mundo de posibilidades que se expande gradualmente.

Esta es, pues, la gran teoría unificada de Gil sobre IBM: que combinando su herencia, su experiencia técnica, la capacidad intelectual de otras personas y su dedicación a los clientes empresariales, puede construir ordenadores cuánticos útiles antes y mejor que nadie.

En esta visión de las cosas, IBM ve la demostración de supremacía cuántica de Google como «un truco de salón», dice Scott Aaronson, físico de la Universidad de Texas en Austin, que contribuyó a los algoritmos cuánticos que Google está utilizando. En el mejor de los casos, es una distracción llamativa del trabajo real que debe realizarse. En el peor de los casos, es engañoso, ya que podría hacer creer a la gente que los ordenadores cuánticos pueden superar a los clásicos en cualquier cosa y no en una tarea muy limitada. «‘Supremacía’ es una palabra inglesa que va a ser imposible que el público no malinterprete», dice Gil.

Google, por supuesto, lo ve de forma bastante diferente.

Entre el advenedizo

Google era una empresa precoz de ocho años cuando empezó a juguetear con los problemas cuánticos en 2006, pero no formó un laboratorio cuántico dedicado hasta 2012 -el mismo año en que John Preskill, un físico de Caltech, acuñó el término «supremacía cuántica».»

El director del laboratorio es Hartmut Neven, un informático alemán con una presencia imponente y una predilección por el estilo de Burning Man; lo vi una vez con un abrigo azul peludo y otra con un traje completamente plateado que le hacía parecer un astronauta grunge. («Mi mujer me compra estas cosas», me explicó). Al principio, Neven compró una máquina construida por una empresa externa, D-Wave, y pasó un tiempo intentando alcanzar la supremacía cuántica en ella, pero sin éxito. Cuenta que en 2014 convenció a Larry Page, el entonces consejero delegado de Google, para que invirtiera en la construcción de ordenadores cuánticos prometiéndole que Google asumiría el reto de Preskill: «Le dijimos: ‘Escucha, Larry, en tres años volveremos y pondremos sobre tu mesa un prototipo de chip que pueda, al menos, computar un problema que esté más allá de las capacidades de las máquinas clásicas'»

A falta de la experiencia cuántica de IBM, Google contrató a un equipo externo, liderado por John Martinis, físico de la Universidad de California en Santa Bárbara. Martinis y su grupo ya se encontraban entre los mejores creadores de ordenadores cuánticos del mundo -habían conseguido encadenar hasta nueve qubits- y la promesa de Neven a Page les parecía una meta digna de ser alcanzada.

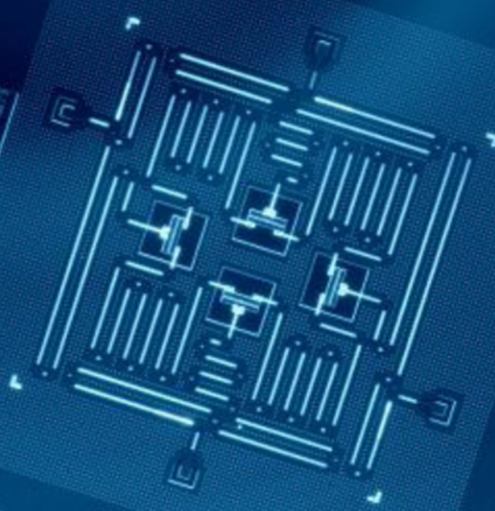

El plazo de tres años se cumplió mientras el equipo de Martinis se esforzaba por fabricar un chip lo suficientemente grande y estable para el reto. En 2018 Google lanzó su mayor procesador hasta la fecha, Bristlecone. Con 72 qubits, estaba muy por delante de todo lo que habían hecho sus rivales, y Martinis predijo que alcanzaría la supremacía cuántica ese mismo año. Pero algunos miembros del equipo habían estado trabajando en paralelo en una arquitectura de chip diferente, llamada Sycamore, que finalmente demostró ser capaz de hacer más con menos qubits. De ahí que fuera un chip de 53 qubits -originalmente 54, pero uno de ellos funcionó mal- el que finalmente demostró la supremacía el pasado otoño.

A efectos prácticos, el programa utilizado en esa demostración es prácticamente inútil: genera números aleatorios, que no es algo para lo que se necesite un ordenador cuántico. Pero los genera de una manera particular que un ordenador clásico encontraría muy difícil de replicar, estableciendo así la prueba de concepto (ver página opuesta).

Pregunte a los de IBM qué piensan de este logro, y obtendrá miradas de dolor. «No me gusta la palabra , y no me gustan las implicaciones», dice Jay Gambetta, un australiano de voz cautelosa que dirige el equipo cuántico de IBM. El problema, dice, es que es prácticamente imposible predecir si un determinado cálculo cuántico será difícil para una máquina clásica, por lo que mostrarlo en un caso no ayuda a encontrar otros casos.

Para todas las personas con las que hablé fuera de IBM, este rechazo a tratar la supremacía cuántica como algo significativo roza la cabezonería. «Cualquiera que vaya a tener una oferta comercialmente relevante, tiene que demostrar primero la supremacía. Creo que es una lógica básica», dice Neven. Incluso Will Oliver, un físico del MIT de modales suaves que ha sido uno de los observadores más ecuánimes de la disputa, dice: «Es un hito muy importante demostrar que un ordenador cuántico supera a un ordenador clásico en alguna tarea, sea cual sea».

El salto cuántico

Independientemente de si se está de acuerdo con la posición de Google o de IBM, el siguiente objetivo está claro, dice Oliver: construir un ordenador cuántico que pueda hacer algo útil. La esperanza es que tales máquinas puedan resolver algún día problemas que ahora requieren cantidades inviables de potencia de cálculo de fuerza bruta, como el modelado de moléculas complejas para ayudar a descubrir nuevos medicamentos y materiales, o la optimización de los flujos de tráfico de la ciudad en tiempo real para reducir la congestión, o hacer predicciones meteorológicas a largo plazo. (Con el tiempo, podrían ser capaces de descifrar los códigos criptográficos que se utilizan hoy en día para asegurar las comunicaciones y las transacciones financieras, aunque para entonces la mayor parte del mundo probablemente habrá adoptado una criptografía resistente a la tecnología cuántica). El problema es que es casi imposible predecir cuál será la primera tarea útil, o el tamaño que necesitará un ordenador para realizarla.

Esa incertidumbre tiene que ver tanto con el hardware como con el software. En cuanto al hardware, Google calcula que sus diseños de chip actuales pueden llegar a entre 100 y 1.000 qubits. Sin embargo, al igual que el rendimiento de un coche no depende únicamente del tamaño del motor, el rendimiento de un ordenador cuántico no viene determinado simplemente por su número de qubits. Hay que tener en cuenta otros factores, como el tiempo que se puede evitar que se descoherencien, su propensión a los errores, su velocidad de funcionamiento y su interconexión. Esto significa que cualquier ordenador cuántico que funcione hoy en día sólo alcanza una fracción de todo su potencial.

El software para los ordenadores cuánticos, mientras tanto, está tan en pañales como las propias máquinas. En la computación clásica, los lenguajes de programación están ahora a varios niveles de distancia del «código máquina» en bruto que los primeros desarrolladores de software tenían que utilizar, porque el meollo de cómo se almacenan, procesan y desplazan los datos ya está estandarizado. «En un ordenador clásico, cuando lo programas, no tienes que saber cómo funciona un transistor», dice Dave Bacon, que dirige el equipo de software de Google. El código cuántico, en cambio, tiene que estar muy adaptado a los qubits en los que se ejecutará, para sacar el máximo partido a su temperamental rendimiento. Esto significa que el código de los chips de IBM no funcionará en los de otras empresas, e incluso las técnicas para optimizar el Sycamore de 53 qubits de Google no necesariamente funcionarán bien en su futuro hermano de 100 qubits. Y lo que es más importante, significa que nadie puede predecir la dificultad de los problemas que esos 100 qubits serán capaces de abordar.

Lo máximo que se puede esperar es que los ordenadores con unos pocos cientos de qubits sean capaces de simular alguna química medianamente compleja en los próximos años, tal vez incluso lo suficiente como para avanzar en la búsqueda de un nuevo medicamento o una batería más eficiente. Sin embargo, la decoherencia y los errores harán que todas estas máquinas se detengan antes de que puedan hacer algo realmente difícil como romper la criptografía.

Para construir un ordenador cuántico con la potencia de 1.000 qubits, se necesitaría un millón de qubits reales.

Eso requerirá un ordenador cuántico «tolerante a fallos», que pueda compensar los errores y seguir funcionando indefinidamente, tal y como hacen los clásicos. La solución prevista será crear redundancia: hacer que cientos de qubits actúen como uno solo, en un estado cuántico compartido. Colectivamente, pueden corregir los errores de los qubits individuales. Y cuando cada qubit sucumba a la decoherencia, sus vecinos lo devolverán a la vida, en un ciclo interminable de reanimación mutua.

La predicción típica es que se necesitarían hasta 1.000 qubits unidos para alcanzar esa estabilidad, lo que significa que para construir un ordenador con la potencia de 1.000 qubits, se necesitarían un millón de qubits reales. Google estima «conservadoramente» que puede construir un procesador de un millón de qubits dentro de 10 años, dice Neven, aunque hay algunos grandes obstáculos técnicos que superar, incluyendo uno en el que IBM todavía puede tener la ventaja sobre Google (ver página opuesta).

Para entonces, muchas cosas habrán cambiado. Los qubits superconductores que Google e IBM utilizan actualmente podrían ser los tubos de vacío de su época, sustituidos por algo mucho más estable y fiable. Investigadores de todo el mundo están experimentando con diversos métodos para fabricar qubits, aunque pocos están lo suficientemente avanzados como para construir ordenadores que funcionen. Empresas emergentes rivales como Rigetti, IonQ o Quantum Circuits podrían desarrollar una ventaja en una técnica concreta y adelantarse a las empresas más grandes.

Cuento de dos transmones

Los qubits de transmón de Google e IBM son casi idénticos, con una pequeña pero potencialmente crucial diferencia.

En los ordenadores cuánticos de Google e IBM, los propios qubits se controlan mediante pulsos de microondas. Pequeños defectos de fabricación hacen que no haya dos qubits que respondan a pulsos de exactamente la misma frecuencia. Hay dos soluciones para esto: variar la frecuencia de los pulsos para encontrar el punto dulce de cada qubit, como sacudir una llave mal cortada en una cerradura hasta que se abra; o usar campos magnéticos para «sintonizar» cada qubit con la frecuencia correcta.

IBM utiliza el primer método; Google, el segundo. Cada enfoque tiene ventajas y desventajas. Los qubits sintonizables de Google funcionan más rápido y con mayor precisión, pero son menos estables y requieren más circuitos. Los qubits de frecuencia fija de IBM son más estables y sencillos, pero funcionan con más lentitud.

Desde un punto de vista técnico, la cosa está bastante reñida, al menos en esta fase. Sin embargo, en términos de filosofía corporativa, es la diferencia entre Google e IBM en una cáscara de nuez, o mejor dicho, en un qubit.

Google ha optado por ser ágil. «En general, nuestra filosofía va un poco más hacia una mayor controlabilidad a expensas de los números que la gente suele buscar», dice Hartmut Neven.

IBM, por su parte, eligió la fiabilidad. «Hay una gran diferencia entre hacer un experimento de laboratorio y publicar un artículo, y poner un sistema con, por ejemplo, un 98% de fiabilidad en el que puedas funcionar todo el tiempo», dice Darío Gil.

Ahora mismo, Google tiene ventaja. Sin embargo, a medida que las máquinas se hacen más grandes, la ventaja puede pasar a IBM. Cada qubit está controlado por sus propios cables individuales; un qubit ajustable requiere un cable adicional. La creación de un cableado para miles o millones de qubits será uno de los retos técnicos más difíciles a los que se enfrenten las dos empresas; IBM dice que es una de las razones por las que eligieron el qubit de frecuencia fija. Martinis, el jefe del equipo de Google, dice que ha pasado personalmente los últimos tres años tratando de encontrar soluciones de cableado. «Es un problema tan importante que he trabajado en él», bromea.

Pero dado su tamaño y riqueza, tanto Google como IBM tienen posibilidades de convertirse en actores serios en el negocio de la computación cuántica. Las empresas alquilarán sus máquinas para abordar los problemas de la misma manera que actualmente alquilan el almacenamiento de datos en la nube y la capacidad de procesamiento de Amazon, Google, IBM o Microsoft. Y lo que comenzó como una batalla entre físicos e informáticos evolucionará hacia una competencia entre las divisiones de servicios empresariales y los departamentos de marketing.

¿Qué empresa está mejor situada para ganar esa contienda? IBM, con sus ingresos en declive, puede tener un mayor sentido de la urgencia que Google. Conoce por amarga experiencia los costes de ser lentos en entrar en un mercado: el verano pasado, en su compra más cara, desembolsó 34.000 millones de dólares por Red Hat, un proveedor de servicios en la nube de código abierto, en un intento de alcanzar a Amazon y Microsoft en ese campo y revertir su suerte financiera. Su estrategia de poner sus máquinas cuánticas en la nube y construir un negocio de pago desde el principio parece diseñada para darle una ventaja.

Google comenzó recientemente a seguir el ejemplo de IBM, y entre sus clientes comerciales se encuentran ahora el Departamento de Energía de Estados Unidos, Volkswagen y Daimler. La razón por la que no lo hizo antes, dice Martinis, es sencilla: «No teníamos los recursos para ponerlo en la nube». Pero esa es otra forma de decir que se dio el lujo de no tener que hacer del desarrollo del negocio una prioridad.

Si esa decisión le da a IBM una ventaja es demasiado pronto para decirlo, pero probablemente lo más importante será cómo las dos compañías apliquen sus otras fortalezas al problema en los próximos años. Según Gil, IBM se beneficiará de su experiencia «completa» en todos los ámbitos, desde la ciencia de los materiales y la fabricación de chips hasta el servicio a grandes clientes corporativos. Google, por su parte, puede presumir de tener una cultura de innovación al estilo de Silicon Valley y mucha práctica en la ampliación rápida de operaciones.

En cuanto a la supremacía cuántica en sí, será un momento importante en la historia, pero eso no significa que sea decisivo. After all, everyone knows about the Wright brothers’ first flight, but can anybody remember what they did afterwards?

Sign inSubscribe now