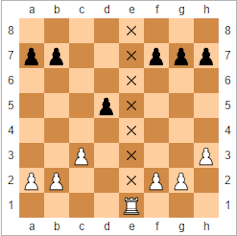

Au septième coup de la partie décisive, les noirs ont commis ce que certains considèrent aujourd’hui comme une erreur critique. Lorsque les noirs ont mélangé les coups pour la défense Caro-Kann, les blancs en ont profité et ont créé une nouvelle attaque en sacrifiant un chevalier. En seulement 11 coups supplémentaires, les blancs ont construit une position si forte que les noirs n’ont pas eu d’autre choix que de concéder la défaite. Le perdant a réagi en criant à la tricherie – l’une des accusations de tricherie les plus stridentes jamais formulées dans un tournoi, qui a déclenché une théorie de la conspiration internationale toujours remise en question 20 ans plus tard.

Ce n’était pas une partie d’échecs ordinaire. Il n’est pas rare qu’un joueur vaincu accuse son adversaire de tricherie – mais dans ce cas, le perdant était le champion du monde d’échecs de l’époque, Garry Kasparov. Le vainqueur était encore plus inhabituel : le superordinateur d’IBM, Deep Blue.

En battant Kasparov le 11 mai 1997, Deep Blue est entré dans l’histoire comme le premier ordinateur à battre un champion du monde dans un match de six parties sous contrôle de temps standard. Kasparov avait gagné la première partie, perdu la deuxième, puis fait match nul dans les trois suivantes. Lorsque Deep Blue a remporté le match en gagnant la dernière partie, Kasparov a refusé d’y croire.

En écho aux canulars d’automates d’échecs des 18e et 19e siècles, Kasparov a soutenu que l’ordinateur devait en réalité avoir été contrôlé par un véritable grand maître. Lui et ses partisans estimaient que le jeu de Deep Blue était trop humain pour être celui d’une machine. Pendant ce temps, pour beaucoup de ceux qui, dans le monde extérieur, étaient convaincus par les performances de l’ordinateur, il semblait que l’intelligence artificielle avait atteint un stade où elle pouvait dépasser l’humanité – du moins à un jeu qui avait longtemps été considéré comme trop complexe pour une machine.

Écoutez une version audio de cet article sur le podcast In Depth Out Loud de The Conversation.

En réalité, la victoire de Deep Blue était précisément due à son engagement rigide, non humain, à la logique froide et dure face au comportement émotionnel de Kasparov. Ce n’était pas une intelligence artificielle (ou réelle) qui démontrait notre propre style créatif de pensée et d’apprentissage, mais l’application de règles simples à grande échelle.

Ce que le match a fait, cependant, c’est signaler le début d’un changement sociétal qui gagne en vitesse et en influence aujourd’hui. Le type de traitement de vastes données sur lequel Deep Blue s’est appuyé se retrouve désormais dans presque tous les coins de nos vies, des systèmes financiers qui dominent l’économie aux applications de rencontres en ligne qui tentent de nous trouver le partenaire idéal. Ce qui a commencé comme un projet étudiant, a contribué à inaugurer l’ère du big data.

Une erreur humaine

La base des revendications de Kasparov remontait à un coup que l’ordinateur avait fait lors de la deuxième partie du match, la première de la compétition que Deep Blue a gagnée. Kasparov avait joué pour encourager son adversaire à prendre un pion « empoisonné », une pièce sacrificielle positionnée pour inciter la machine à faire un coup fatal. C’était une tactique que Kasparov avait utilisée contre des adversaires humains dans le passé.

Ce qui a surpris Kasparov, c’est le coup suivant de Deep Blue. Kasparov l’a qualifié d' »humain ». John Nunn, le grand maître d’échecs anglais, l’a décrit comme « stupéfiant » et « exceptionnel ». Le coup a mis Kasparov en colère et l’a finalement détourné de sa stratégie. Il est si perturbé qu’il finit par abandonner la partie, perdant ainsi le match. Pire encore, il ne s’est jamais remis, faisant match nul dans les trois parties suivantes, puis commettant l’erreur qui a conduit à sa perte dans la dernière partie.

Ce coup était basé sur l’avantage stratégique qu’un joueur peut obtenir en créant une file ouverte, une colonne de cases sur le plateau (vue de dessus) qui ne contient aucune pièce. Cela peut créer une voie d’attaque, généralement pour les tours ou les dames, sans pions bloquant le chemin. Au cours de son entraînement avec le grand maître Joel Benjamin, l’équipe de Deep Blue avait appris qu’il existait parfois une option plus stratégique que d’ouvrir une colonne et d’y déplacer une tour. Au lieu de cela, la tactique consistait à empiler des pièces sur le dossier, puis à choisir le moment de l’ouvrir.

Lorsque les programmeurs ont appris cela, ils ont réécrit le code de Deep Blue pour intégrer ces mouvements. Au cours de la partie, l’ordinateur a utilisé la position d’avoir un fichier potentiellement ouvert pour mettre la pression sur Kasparov et le forcer à défendre à chaque coup. Cet avantage psychologique a fini par avoir raison de Kasparov.

Dès le moment où Kasparov a perdu, les spéculations et les théories du complot ont commencé. Les conspirationnistes ont affirmé qu’IBM avait eu recours à une intervention humaine pendant le match. IBM a démenti, déclarant que, conformément aux règles, la seule intervention humaine est intervenue entre les parties pour rectifier des bugs qui avaient été identifiés pendant le jeu. IBM a également rejeté l’affirmation selon laquelle la programmation avait été adaptée au style de jeu de Kasparov. Au lieu de cela, ils s’étaient appuyés sur la capacité de l’ordinateur à rechercher parmi un nombre énorme de coups possibles.

Le refus par IBM de la demande de Kasparov pour une revanche et le démantèlement ultérieur de Deep Blue n’ont rien fait pour apaiser les soupçons. IBM a également retardé la publication des journaux détaillés de l’ordinateur, comme Kasparov l’avait également demandé, jusqu’après le démantèlement. Mais l’analyse détaillée des journaux qui a suivi a ajouté de nouvelles dimensions à l’histoire, notamment en permettant de comprendre que Deep Blue a commis plusieurs grosses erreurs.

Il y a depuis des spéculations selon lesquelles Deep Blue n’aurait triomphé qu’à cause d’un bug dans le code lors de la première partie. L’un des concepteurs de Deep Blue a déclaré que lorsqu’un pépin empêchait l’ordinateur de sélectionner l’un des coups qu’il avait analysés, il effectuait à la place un coup aléatoire que Kasparov interprétait à tort comme une stratégie plus profonde.

Il est parvenu à remporter la partie et le bug a été corrigé pour la deuxième manche. Mais le champion du monde aurait été tellement ébranlé par ce qu’il considérait comme l’intelligence supérieure de la machine qu’il n’a pas pu retrouver son calme et a joué trop prudemment à partir de ce moment-là. Il a même raté l’occasion de revenir sur la tactique du fichier ouvert lorsque Deep Blue a fait une « terrible gaffe ».

Quoi que soient ces récits des réactions de Kasparov au match, ils soulignent le fait que sa défaite était au moins en partie due aux fragilités de la nature humaine. Il a trop réfléchi à certains mouvements de la machine et s’est inutilement inquiété de ses capacités, commettant des erreurs qui ont finalement conduit à sa défaite. Deep Blue ne possédait rien qui ressemble aux techniques d’intelligence artificielle qui, aujourd’hui, ont aidé les ordinateurs à gagner à des jeux bien plus complexes, comme le Go.

Mais même si Kasparov était plus intimidé qu’il n’aurait dû l’être, on ne peut nier les réalisations étonnantes de l’équipe qui a créé Deep Blue. Sa capacité à affronter le meilleur joueur d’échecs humain du monde s’est appuyée sur une puissance de calcul incroyable, qui a lancé le programme de supercalculateurs IBM, lequel a ouvert la voie à certaines des technologies de pointe disponibles dans le monde aujourd’hui. Ce qui rend cela encore plus étonnant, c’est le fait que le projet a démarré non pas comme un projet exubérant de l’un des plus grands fabricants d’ordinateurs, mais comme une thèse d’étudiant dans les années 1980.

La course aux échecs

Lorsque Feng-Hsiung Hsu est arrivé aux États-Unis en provenance de Taïwan en 1982, il ne peut pas avoir imaginé qu’il ferait partie d’une intense rivalité entre deux équipes qui ont passé près d’une décennie à rivaliser pour construire le meilleur ordinateur d’échecs au monde. M. Hsu était venu à l’université Carnegie Mellon (CMU) en Pennsylvanie pour étudier la conception des circuits intégrés qui composent les micropuces, mais il s’intéressait aussi depuis longtemps aux échecs informatiques. Il a attiré l’attention des développeurs de Hitech, l’ordinateur qui, en 1988, deviendrait le premier à battre un grand maître d’échecs, et on lui a demandé d’aider à la conception du matériel.

Mais Hsu s’est rapidement brouillé avec l’équipe de Hitech après avoir découvert ce qu’il considérait comme une faille architecturale dans la conception qu’ils proposaient. Avec plusieurs autres doctorants, il a commencé à construire son propre ordinateur connu sous le nom de ChipTest, en s’inspirant de l’architecture de la machine d’échecs du Bell Laboratory, Belle. La technologie personnalisée de ChipTest utilisait ce qu’on appelle « l’intégration à très grande échelle » pour combiner des milliers de transistors sur une seule puce, permettant à l’ordinateur de rechercher 500 000 coups d’échecs par seconde.

Bien que l’équipe de Hitech ait eu une longueur d’avance, Hsu et ses collègues allaient bientôt les dépasser avec le successeur de ChipTest. Deep Thought – nommé d’après l’ordinateur du Guide du routard galactique de Douglas Adams construit pour trouver le sens de la vie – combinait deux des processeurs personnalisés de Hsu et pouvait analyser 720 000 coups par seconde. Cela lui a permis de remporter le championnat mondial d’échecs par ordinateur de 1989 sans perdre une seule partie.

Mais Deep Thought a rencontré un obstacle plus tard dans l’année lorsqu’il s’est confronté (et a perdu) au champion du monde d’échecs en titre, un certain Garry Kasparov. Pour battre le meilleur de l’humanité, Hsu et son équipe devraient aller beaucoup plus loin. Mais maintenant, ils avaient le soutien du géant de l’informatique IBM.

Les ordinateurs d’échecs fonctionnent en attachant une valeur numérique à la position de chaque pièce sur l’échiquier à l’aide d’une formule appelée « fonction d’évaluation ». Ces valeurs peuvent ensuite être traitées et recherchées pour déterminer le meilleur coup à effectuer. Les premiers ordinateurs d’échecs, comme Belle et Hitech, utilisaient plusieurs puces personnalisées pour exécuter les fonctions d’évaluation et combiner ensuite les résultats ensemble.

Le problème était que la communication entre les puces était lente et consommait beaucoup de puissance de traitement. Ce que Hsu a fait avec ChipTest a été de reconcevoir et de reconditionner les processeurs en une seule puce. Cela a permis de supprimer un certain nombre de frais généraux de traitement, comme la communication hors puce, et d’augmenter considérablement la vitesse de calcul. Alors que Deep Thought pouvait traiter 720 000 coups par seconde, Deep Blue a utilisé un grand nombre de processeurs exécutant simultanément le même ensemble de calculs pour analyser 100 000 000 de coups par seconde.

L’augmentation du nombre de coups que l’ordinateur pouvait traiter était importante car les ordinateurs d’échecs ont traditionnellement utilisé des techniques dites de « force brute ». Les joueurs humains apprennent de leur expérience passée à exclure instantanément certains coups. Les machines d’échecs, en tout cas à l’époque, n’avaient pas cette capacité et devaient plutôt compter sur leur capacité à anticiper ce qui pourrait se passer pour chaque coup possible. Elles utilisaient la force brute pour analyser un très grand nombre de coups plutôt que de se concentrer sur certains types de coups dont elles savaient déjà qu’ils étaient les plus susceptibles de fonctionner. L’augmentation du nombre de coups qu’une machine pouvait examiner en une seconde lui donnait le temps de regarder beaucoup plus loin dans le futur où les différents coups mèneraient le jeu.

En février 1996, l’équipe d’IBM était prête à affronter Kasparov à nouveau, cette fois avec Deep Blue. Bien qu’il soit devenu la première machine à battre un champion du monde dans une partie sous contrôle de temps régulier, Deep Blue a perdu le match global 4-2. Ses 100 000 000 de coups par seconde n’étaient toujours pas suffisants pour battre la capacité humaine à établir des stratégies.

Pour augmenter le nombre de coups, l’équipe a commencé à améliorer la machine en explorant comment optimiser un grand nombre de processeurs travaillant en parallèle – avec un grand succès. La machine finale était un superordinateur de 30 processeurs qui, plus important encore, contrôlait 480 circuits intégrés personnalisés conçus spécifiquement pour jouer aux échecs. C’est cette conception personnalisée qui a permis à l’équipe d’optimiser à ce point la puissance de calcul parallèle des puces. Le résultat est une nouvelle version de Deep Blue (parfois appelée Deeper Blue) capable de rechercher environ 200 000 000 de coups par seconde. Cela signifie qu’il pouvait explorer comment chaque stratégie possible se déroulerait jusqu’à 40 coups ou plus dans le futur.

Révolution parallèle

Au moment où la revanche a eu lieu à New York en mai 1997, la curiosité du public était énorme. Les journalistes et les caméras de télévision se pressent autour de l’échiquier et sont récompensés par un article lorsque Kasparov part en trombe après sa défaite et crie au scandale lors de la conférence de presse qui suit. Mais la publicité faite autour du match a également permis de mieux comprendre les progrès accomplis par les ordinateurs. Ce dont la plupart des gens n’avaient encore aucune idée, c’est de la façon dont la technologie derrière Deep Blue allait contribuer à étendre l’influence des ordinateurs à presque tous les aspects de la société en transformant la façon dont nous utilisons les données.

Des modèles informatiques complexes sont aujourd’hui utilisés pour étayer les systèmes financiers des banques, pour concevoir de meilleures voitures et de meilleurs avions, et pour tester de nouveaux médicaments. Les systèmes qui exploitent de grands ensembles de données (souvent appelés « big data ») pour rechercher des modèles significatifs interviennent dans la planification de services publics tels que les transports ou les soins de santé, et permettent aux entreprises de cibler la publicité sur des groupes de personnes spécifiques.

Il s’agit de problèmes très complexes qui nécessitent un traitement rapide de grands ensembles de données complexes. Deep Blue a donné aux scientifiques et aux ingénieurs un aperçu significatif des systèmes multi-puces massivement parallèles qui ont rendu cela possible. Ils ont notamment montré les capacités d’un système informatique polyvalent qui contrôlait un grand nombre de puces personnalisées conçues pour une application spécifique.

La science de la dynamique moléculaire, par exemple, consiste à étudier les mouvements physiques des molécules et des atomes. Les conceptions de puces personnalisées ont permis aux ordinateurs de modéliser la dynamique moléculaire pour regarder à l’avance comment de nouveaux médicaments pourraient réagir dans le corps, tout comme on regarde à l’avance les différents coups d’échecs. Les simulations de dynamique moléculaire ont permis d’accélérer le développement de médicaments efficaces, comme certains de ceux utilisés pour traiter le VIH.

Pour des applications très larges, comme la modélisation de systèmes financiers et l’exploration de données, la conception de puces personnalisées pour une tâche individuelle dans ces domaines serait d’un coût prohibitif. Mais le projet Deep Blue a permis de développer les techniques de codage et de gestion de systèmes hautement parallélisés qui répartissent un problème sur un grand nombre de processeurs.

Aujourd’hui, de nombreux systèmes de traitement de grandes quantités de données reposent sur des unités de traitement graphique (GPU) plutôt que sur des puces conçues sur mesure. Celles-ci ont été conçues à l’origine pour produire des images sur un écran, mais aussi pour traiter des informations en utilisant de nombreux processeurs en parallèle. Donc, maintenant, ils sont souvent utilisés dans les ordinateurs à haute performance exécutant de grands ensembles de données et pour faire fonctionner de puissants outils d’intelligence artificielle tels que l’assistant numérique de Facebook. Il y a ici des similitudes évidentes avec l’architecture de Deep Blue : des puces personnalisées (construites pour les graphiques) contrôlées par des processeurs à usage général pour stimuler l’efficacité des calculs complexes.

Le monde des machines à jouer aux échecs, quant à lui, a évolué depuis la victoire de Deep Blue. Malgré son expérience avec Deep Blue, Kasparov a accepté en 2003 de se mesurer à deux des machines à jouer aux échecs les plus en vue, Deep Fritz et Deep Junior. Et les deux fois, il réussit à éviter une défaite, même s’il commet encore des erreurs qui le contraignent à la nullité. Cependant, les deux machines ont battu de manière convaincante leurs homologues humains lors des championnats du monde par équipe Homme contre machine de 2004 et 2005.

Junior et Fritz ont marqué un changement dans l’approche du développement de systèmes pour les échecs par ordinateur. Alors que Deep Blue était un ordinateur sur mesure s’appuyant sur la force brute de ses processeurs pour analyser des millions de coups, ces nouvelles machines d’échecs étaient des logiciels qui utilisaient des techniques d’apprentissage pour minimiser les recherches nécessaires. Cela peut battre les techniques de force brute en utilisant seulement un PC de bureau.

Mais malgré cette avancée, nous n’avons toujours pas de machines d’échecs qui ressemblent à l’intelligence humaine dans la façon dont elle joue le jeu – elles n’en ont pas besoin. Et, s’il y a quelque chose, les victoires de Junior et Fritz renforcent encore l’idée que les joueurs humains perdent face aux ordinateurs, au moins en partie, à cause de leur humanité. Les humains ont fait des erreurs, sont devenus anxieux et ont craint pour leur réputation. Les machines, quant à elles, appliquaient sans relâche des calculs logiques au jeu pour tenter de gagner. Un jour, nous aurons peut-être des ordinateurs qui reproduiront vraiment la pensée humaine, mais l’histoire de ces 20 dernières années a été la montée en puissance de systèmes qui sont supérieurs précisément parce qu’ils sont des machines.