W siódmym ruchu decydującej partii czarne popełniły błąd, który obecnie niektórzy uważają za krytyczny. Kiedy czarne pomieszały ruchy w obronie Caro-Kann, białe wykorzystały to i stworzyły nowy atak, poświęcając rycerza. W ciągu zaledwie 11 kolejnych ruchów białe zbudowały tak silną pozycję, że czarnym nie pozostało nic innego, jak przyznać się do porażki. Przegrany zareagował okrzykiem faulu – jednym z najostrzejszych oskarżeń o oszustwo, jakie kiedykolwiek padło w turnieju, co zapoczątkowało międzynarodową teorię spiskową, która po 20 latach wciąż jest kwestionowana.

To nie była zwykła partia szachów. Nierzadko zdarza się, że pokonany gracz oskarża przeciwnika o oszustwo – ale w tym przypadku przegranym był ówczesny mistrz świata w szachach, Garry Kasparow. Zwycięzca był jeszcze bardziej niezwykły: superkomputer IBM, Deep Blue.

Pokonując Kasparowa 11 maja 1997 r., Deep Blue zapisał się w historii jako pierwszy komputer, który pokonał mistrza świata w meczu sześcioosobowym w standardowej kontroli czasu. Kasparow wygrał pierwszą partię, przegrał drugą, a następnie zremisował trzy kolejne. Kiedy Deep Blue wygrał ostatnią partię meczu, Kasparow nie chciał w to uwierzyć.

W echu oszustw z automatami szachowymi z XVIII i XIX wieku, Kasparow argumentował, że komputer musiał być w rzeczywistości kontrolowany przez prawdziwego arcymistrza. On i jego zwolennicy uważali, że gra Deep Blue jest zbyt ludzka, by mogła być dziełem maszyny. W międzyczasie, dla wielu z tych w świecie zewnętrznym, którzy zostali przekonani przez wyniki komputera, okazało się, że sztuczna inteligencja osiągnęła etap, w którym może przechytrzyć ludzkość – przynajmniej w grze, która przez długi czas była uważana za zbyt skomplikowaną dla maszyny.

Posłuchaj wersji audio tego artykułu w podcaście The Conversation’s In Depth Out Loud.

W rzeczywistości jednak zwycięstwo Deep Blue wynikało właśnie z jego sztywnego, nieludzkiego przywiązania do zimnej, twardej logiki w obliczu emocjonalnego zachowania Kasparowa. To nie była sztuczna (lub prawdziwa) inteligencja, która zademonstrowała nasz własny kreatywny styl myślenia i uczenia się, ale zastosowanie prostych zasad na wielką skalę.

Jednakże mecz ten zasygnalizował początek zmiany społecznej, która dziś nabiera coraz większego tempa i wpływu. Rodzaj ogromnego przetwarzania danych, na którym opierał się Deep Blue, znajduje się obecnie w niemal każdym zakątku naszego życia, od systemów finansowych, które dominują w gospodarce, po internetowe aplikacje randkowe, które próbują znaleźć nam idealnego partnera. To, co zaczęło się jako projekt studencki, pomogło wprowadzić erę big data.

Ludzki błąd

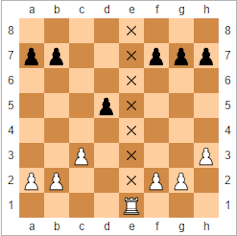

Podstawą roszczeń Kasparowa był ruch, który komputer wykonał w drugiej partii meczu, pierwszej w zawodach, które Deep Blue wygrał. Kasparow zagrał tak, aby zachęcić przeciwnika do wzięcia „zatrutego” pionka, ofiarnego pionka ustawionego tak, aby skusić maszynę do wykonania fatalnego ruchu. Była to taktyka, którą Kasparow stosował w przeszłości przeciwko ludzkim przeciwnikom.

To, co zaskoczyło Kasparowa, to kolejny ruch Deep Blue. Kasparow nazwał go „ludzkim”. John Nunn, angielski arcymistrz szachowy, opisał go jako „oszałamiający” i „wyjątkowy”. Posunięcie to rozwścieczyło Kasparowa, który ostatecznie odrzucił swoją strategię. Był tak zaniepokojony, że w końcu odszedł, przegrywając partię. Co gorsza, nigdy się nie podniósł, remisując kolejne trzy partie, a następnie popełniając błąd, który doprowadził do jego upadku w ostatniej partii.

Ruch ten opierał się na strategicznej przewadze, jaką gracz może uzyskać tworząc otwarty plik, kolumnę kwadratów na planszy (patrząc z góry), która nie zawiera żadnych elementów. Może to stworzyć drogę ataku, zazwyczaj dla gawronów lub królowych, wolną od pionków blokujących drogę. Podczas treningu z wielkim mistrzem Joelem Benjaminem, zespół Deep Blue nauczył się, że czasami istnieje bardziej strategiczna opcja niż otwarcie pliku, a następnie przesunięcie na niego gawrona. Zamiast tego taktyka polegała na umieszczaniu elementów na pliku, a następnie wybieraniu, kiedy go otworzyć.

Kiedy programiści dowiedzieli się o tym, przepisali kod Deep Blue, aby uwzględnić te ruchy. Podczas gry komputer wykorzystał pozycję, w której ma potencjalnie otwarty plik, aby wywrzeć presję na Kasparowie i zmusić go do obrony w każdym ruchu. Ta psychologiczna przewaga w końcu wykończyła Kasparowa.

Od momentu, gdy Kasparow przegrał, zaczęły się spekulacje i teorie spiskowe. Spiskowcy twierdzili, że IBM użył ludzkiej interwencji podczas meczu. IBM zaprzeczył temu, twierdząc, że zgodnie z zasadami, jedyna interwencja człowieka miała miejsce pomiędzy grami, aby naprawić błędy, które zostały wykryte podczas gry. Odrzuciło również twierdzenie, że programowanie zostało dostosowane do stylu gry Kasparowa. Zamiast tego oparli się na zdolności komputera do przeszukiwania ogromnej liczby możliwych ruchów.

Odrzucenie przez IBM prośby Kasparowa o rewanż i późniejszy demontaż Deep Blue nie uspokoiły podejrzeń. IBM zwlekał również z ujawnieniem szczegółowych logów komputera, o co również prosił Kasparow, aż do czasu po jego likwidacji. Jednak późniejsza szczegółowa analiza logów dodała nowe wymiary do tej historii, w tym zrozumienie, że Deep Blue popełnił kilka poważnych błędów.

Od tego czasu pojawiły się spekulacje, że Deep Blue triumfował tylko z powodu błędu w kodzie podczas pierwszej rozgrywki. Jeden z projektantów Deep Blue powiedział, że kiedy błąd uniemożliwił komputerowi wybranie jednego z analizowanych ruchów, zamiast tego wykonał on losowy ruch, który Kasparow błędnie zinterpretował jako głębszą strategię.

Zwyciężył grę, a błąd został naprawiony w drugiej rundzie. Ale mistrz świata był podobno tak wstrząśnięty tym, co postrzegał jako wyższą inteligencję maszyny, że nie był w stanie odzyskać spokoju i od tej pory grał zbyt ostrożnie. Stracił nawet szansę na powrót z taktyki otwartego pliku, gdy Deep Blue popełnił „straszny błąd”.

Którakolwiek z tych relacji o reakcjach Kasparowa na mecz jest prawdziwa, wskazują one na fakt, że jego porażka przynajmniej częściowo wynikała z ułomności ludzkiej natury. Kasparow za bardzo przemyślał niektóre ruchy maszyny i niepotrzebnie przejął się jej możliwościami, popełniając błędy, które ostatecznie doprowadziły do jego porażki. Deep Blue nie posiadał żadnych technik sztucznej inteligencji, które dziś pomagają komputerom wygrywać w dużo bardziej skomplikowanych grach, takich jak Go.

Ale nawet jeśli Kasparow był bardziej onieśmielony, niż potrzebował, nie można zaprzeczyć oszałamiającym osiągnięciom zespołu, który stworzył Deep Blue. Jego zdolność do pokonania najlepszego szachisty na świecie została zbudowana na niesamowitej mocy obliczeniowej, która zapoczątkowała program superkomputerów IBM, który utorował drogę dla niektórych z wiodących technologii dostępnych dziś na świecie. Co czyni to jeszcze bardziej zdumiewającym to fakt, że projekt ten rozpoczął się nie jako wybujały projekt jednego z największych producentów komputerów, ale jako praca studencka w latach 80-tych.

Wyścig szachowy

Kiedy Feng-Hsiung Hsu przybył do USA z Tajwanu w 1982 roku, nie mógł przypuszczać, że stanie się częścią intensywnej rywalizacji pomiędzy dwoma zespołami, które spędziły prawie dekadę walcząc o zbudowanie najlepszego komputera szachowego na świecie. Hsu przybył na Uniwersytet Carnegie Mellon (CMU) w Pensylwanii, aby studiować projektowanie układów scalonych tworzących mikroprocesory, ale od dawna interesował się również szachami komputerowymi. Zwrócił na siebie uwagę twórców Hitech, komputera, który w 1988 roku jako pierwszy pokonał arcymistrza szachowego, i został poproszony o pomoc przy projektowaniu sprzętu.

Jednakże Hsu szybko zerwał kontakt z zespołem Hitech po tym, jak odkrył to, co uznał za wadę architektoniczną w proponowanym przez nich projekcie. Wraz z kilkoma innymi doktorantami rozpoczął budowę własnego komputera, znanego jako ChipTest, wzorując się na architekturze maszyny szachowej Belle z Bell Laboratory. Niestandardowa technologia ChipTestu wykorzystała tak zwaną „integrację na bardzo dużą skalę” do połączenia tysięcy tranzystorów na jednym chipie, co pozwoliło komputerowi na przeszukiwanie 500 000 ruchów szachowych w każdej sekundzie.

Chociaż zespół Hitech miał przewagę, Hsu i jego koledzy wkrótce ich wyprzedzili, tworząc następcę ChipTestu. Deep Thought – nazwany tak na cześć komputera z książki Douglasa Adamsa „Autostopem przez galaktykę” (The Hitchhiker’s Guide to the Galaxy), zbudowanego w celu odnalezienia sensu życia – łączył w sobie dwa niestandardowe procesory Hsu i był w stanie przeanalizować 720 000 ruchów na sekundę. Umożliwiło mu to wygranie Mistrzostw Świata w Szachach Komputerowych w 1989 roku bez przegrania ani jednej partii.

Ale Deep Thought natrafił na przeszkodę jeszcze w tym samym roku, gdy zmierzył się (i przegrał) z panującym mistrzem świata w szachach, niejakim Garrym Kasparowem. Aby pokonać najlepszych z ludzi, Hsu i jego zespół musieliby pójść znacznie dalej. Teraz jednak mieli wsparcie giganta komputerowego IBM.

Komputery szachowe działają poprzez przypisanie wartości liczbowej do pozycji każdej bierki na planszy za pomocą formuły znanej jako „funkcja oceny”. Wartości te mogą być następnie przetwarzane i wyszukiwane w celu określenia najlepszego ruchu do wykonania. Wczesne komputery szachowe, takie jak Belle i Hitech, wykorzystywały wiele niestandardowych chipów do uruchamiania funkcji oceny, a następnie łączenia wyników razem.

Problem polegał na tym, że komunikacja między chipami była powolna i zużywała dużo mocy obliczeniowej. To, co Hsu zrobił z ChipTestem, to przeprojektowanie i przepakowanie procesorów w jeden układ. Pozwoliło to na usunięcie wielu przeszkód w przetwarzaniu danych, takich jak komunikacja poza układem scalonym, i umożliwiło ogromny wzrost prędkości obliczeniowej. Podczas gdy Deep Thought mógł przetwarzać 720 000 ruchów na sekundę, Deep Blue używał dużej liczby procesorów wykonujących ten sam zestaw obliczeń jednocześnie, aby analizować 100 000 000 ruchów na sekundę.

Zwiększenie liczby ruchów, które komputer może przetworzyć, było ważne, ponieważ komputery szachowe tradycyjnie używają tak zwanych technik „brute force”. Ludzie uczą się na podstawie wcześniejszych doświadczeń, aby natychmiast wykluczyć pewne ruchy. Maszyny szachowe, z pewnością w tamtych czasach, nie miały takiej możliwości i zamiast tego musiały polegać na swojej umiejętności przewidywania, co może się wydarzyć w każdym możliwym ruchu. Używały brutalnej siły do analizowania bardzo dużej liczby ruchów, zamiast skupiać się na pewnych typach posunięć, o których wiedziały, że są najbardziej prawdopodobne. Zwiększenie liczby ruchów, które maszyna może przeanalizować w ciągu sekundy, dało jej czas na spojrzenie znacznie dalej w przyszłość, gdzie różne ruchy doprowadzą grę.

Do lutego 1996 roku zespół IBM był gotowy, aby ponownie zmierzyć się z Kasparowem, tym razem z Deep Blue. Choć Deep Blue stał się pierwszą maszyną, która pokonała mistrza świata w grze pod kontrolą czasu, przegrał cały mecz 4-2. Jego 100 000 000 ruchów na sekundę to wciąż za mało, aby pokonać ludzkie zdolności strategiczne.

Aby zwiększyć liczbę ruchów, zespół zaczął ulepszać maszynę, badając możliwości optymalizacji dużej liczby procesorów pracujących równolegle – z wielkim sukcesem. Ostateczna maszyna była 30-procesorowym superkomputerem, który, co ważniejsze, kontrolował 480 niestandardowych, zintegrowanych obwodów zaprojektowanych specjalnie do gry w szachy. Ta niestandardowa konstrukcja umożliwiła zespołowi tak wysoką optymalizację mocy obliczeń równoległych we wszystkich układach. W rezultacie powstała nowa wersja Deep Blue (czasami nazywana Deeper Blue) zdolna do przeszukiwania około 200 000 000 ruchów na sekundę. Oznaczało to, że może ona zbadać, jak każda możliwa strategia będzie wyglądać do 40 lub więcej ruchów w przyszłości.

Rewolucja równoległa

Do czasu rewanżu, który miał miejsce w Nowym Jorku w maju 1997 roku, ciekawość opinii publicznej była ogromna. Reporterzy i kamery telewizyjne roiły się wokół planszy i zostały nagrodzone artykułem, gdy Kasparow po porażce rzucił się do ucieczki i płakał na konferencji prasowej. Ale rozgłos wokół meczu pomógł również w lepszym zrozumieniu tego, jak daleko zaszły komputery. Większość ludzi wciąż nie miała pojęcia o tym, jak technologia stojąca za Deep Blue pomoże rozszerzyć wpływ komputerów na niemal każdy aspekt społeczeństwa, przekształcając sposób, w jaki korzystamy z danych.

Komplikowane modele komputerowe są dziś wykorzystywane do wspierania systemów finansowych banków, projektowania lepszych samochodów i samolotów oraz testowania nowych leków. Systemy, które badają duże zbiory danych (często znane jako „big data”) w poszukiwaniu istotnych wzorców, biorą udział w planowaniu usług publicznych, takich jak transport czy opieka zdrowotna, i umożliwiają firmom kierowanie reklam do określonych grup ludzi.

Są to bardzo złożone problemy, które wymagają szybkiego przetwarzania dużych i złożonych zbiorów danych. Deep Blue dał naukowcom i inżynierom znaczący wgląd w masowo równoległe systemy wielochipowe, które to umożliwiły. W szczególności pokazał możliwości systemu komputerowego ogólnego przeznaczenia, który kontrolował dużą liczbę niestandardowych chipów zaprojektowanych do konkretnych zastosowań.

Nauka dynamiki molekularnej, na przykład, obejmuje badanie fizycznych ruchów cząsteczek i atomów. Niestandardowe projekty chipów umożliwiły komputerom modelowanie dynamiki molekularnej, aby zobaczyć z wyprzedzeniem, jak nowe leki mogą reagować w organizmie, podobnie jak patrzenie z wyprzedzeniem na różne ruchy szachowe. Symulacje dynamiki molekularnej pomogły przyspieszyć rozwój skutecznych leków, takich jak niektóre z tych stosowanych w leczeniu HIV.

W przypadku bardzo szerokich zastosowań, takich jak modelowanie systemów finansowych i eksploracja danych, projektowanie niestandardowych chipów do pojedynczych zadań w tych dziedzinach byłoby zaporowo drogie. Jednak projekt Deep Blue pomógł opracować techniki kodowania i zarządzania wysoce równoległymi systemami, które rozdzielają problem na dużą liczbę procesorów.

Dziś wiele systemów do przetwarzania dużych ilości danych opiera się na procesorach graficznych (GPU) zamiast na układach projektowanych na zamówienie. Zostały one pierwotnie zaprojektowane do generowania obrazów na ekranie, ale także do przetwarzania informacji przy użyciu wielu równoległych procesorów. Dlatego teraz są one często wykorzystywane w wysokowydajnych komputerach obsługujących duże zbiory danych oraz do uruchamiania potężnych narzędzi sztucznej inteligencji, takich jak cyfrowy asystent Facebooka. Istnieją tu oczywiste podobieństwa do architektury Deep Blue: niestandardowe układy (zbudowane dla grafiki) kontrolowane przez procesory ogólnego przeznaczenia w celu zwiększenia wydajności złożonych obliczeń.

Świat maszyn do gry w szachy, w międzyczasie, ewoluował od czasu zwycięstwa Deep Blue. Pomimo doświadczeń z Deep Blue, Kasparow zgodził się w 2003 roku zmierzyć z dwoma najbardziej znanymi maszynami szachowymi, Deep Fritz i Deep Junior. I w obu przypadkach udało mu się uniknąć porażki, choć wciąż popełniał błędy, które zmusiły go do remisu. Jednak obie maszyny przekonująco pokonały swoich ludzkich odpowiedników w Drużynowych Mistrzostwach Świata Człowiek vs Maszyna w 2004 i 2005 roku.

Junior i Fritz oznaczają zmianę w podejściu do tworzenia systemów dla szachów komputerowych. Podczas gdy Deep Blue był komputerem zbudowanym na zamówienie, polegającym na brutalnej sile swoich procesorów w celu przeanalizowania milionów ruchów, te nowe maszyny szachowe były programami, które wykorzystywały techniki uczenia się w celu zminimalizowania potrzebnych wyszukiwań. To może pokonać techniki brute force przy użyciu tylko komputera stacjonarnego.

Ale pomimo tego postępu, nadal nie mamy maszyn szachowych, które przypominają ludzką inteligencję w sposobie gry – nie muszą. Zwycięstwa Juniora i Fritza jeszcze bardziej utwierdzają nas w przekonaniu, że ludzcy gracze przegrywają z komputerami, przynajmniej częściowo, z powodu swojego człowieczeństwa. Ludzie popełniali błędy, denerwowali się i bali o swoją reputację. Maszyny, z drugiej strony, niestrudzenie stosowały logiczne obliczenia w grze, starając się wygrać. Pewnego dnia być może będziemy mieli komputery, które naprawdę odtworzą ludzkie myślenie, ale historia ostatnich 20 lat to powstanie systemów, które są lepsze właśnie dlatego, że są maszynami.