En la séptima jugada de la crucial partida decisiva, las negras cometieron lo que algunos consideran ahora un error crítico. Cuando las negras confundieron las jugadas de la defensa Caro-Kann, las blancas aprovecharon y crearon un nuevo ataque sacrificando un caballo. En sólo 11 movimientos más, las blancas habían construido una posición tan fuerte que las negras no tuvieron más remedio que conceder la derrota. El perdedor reaccionó con un grito de juego sucio: una de las más estridentes acusaciones de trampas jamás hechas en un torneo, que encendió una teoría de la conspiración internacional que aún se cuestiona 20 años después.

Esta no era una partida de ajedrez cualquiera. No es raro que un jugador derrotado acuse a su oponente de hacer trampas, pero en este caso el perdedor era el entonces campeón mundial de ajedrez, Garry Kasparov. El vencedor fue aún más inusual: el superordenador de IBM, Deep Blue.

Al derrotar a Kasparov el 11 de mayo de 1997, Deep Blue hizo historia al ser el primer ordenador en vencer a un campeón del mundo en una partida de seis juegos bajo controles de tiempo estándar. Kasparov había ganado la primera partida, perdido la segunda y empatado las tres siguientes. Cuando Deep Blue se llevó el partido al ganar la última partida, Kasparov se negó a creerlo.

En un eco de los bulos sobre autómatas de ajedrez de los siglos XVIII y XIX, Kaspárov argumentó que el ordenador debía haber sido controlado realmente por un gran maestro. Él y sus partidarios creían que el juego de Deep Blue era demasiado humano para ser el de una máquina. Mientras tanto, para muchos de los que en el mundo exterior estaban convencidos de la actuación del ordenador, parecía que la inteligencia artificial había alcanzado una etapa en la que podía superar a la humanidad, al menos en un juego que durante mucho tiempo se había considerado demasiado complejo para una máquina.

Escucha una versión en audio de este artículo en el podcast In Depth Out Loud de The Conversation.

Pero la realidad fue que la victoria de Deep Blue se debió precisamente a su compromiso rígido y poco humano con la lógica fría y dura frente al comportamiento emocional de Kasparov. No se trataba de una inteligencia artificial (o real) que demostrara nuestro propio estilo creativo de pensamiento y aprendizaje, sino de la aplicación de reglas simples a gran escala.

Sin embargo, lo que sí hizo el partido fue señalar el inicio de un cambio social que está ganando cada vez más velocidad e influencia en la actualidad. El tipo de procesamiento de datos en el que se basó Deep Blue se encuentra ahora en casi todos los rincones de nuestras vidas, desde los sistemas financieros que dominan la economía hasta las aplicaciones de citas online que tratan de encontrarnos la pareja perfecta. Lo que empezó como un proyecto estudiantil, ayudó a inaugurar la era del big data.

Un error humano

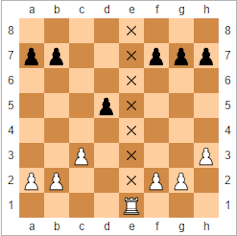

La base de las reclamaciones de Kaspárov se remonta a una jugada que hizo el ordenador en la segunda partida del encuentro, la primera de la competición que ganó Deep Blue. Kasparov había jugado para animar a su oponente a tomar un peón «envenenado», una pieza de sacrificio colocada para atraer a la máquina a realizar una jugada fatídica. Esta era una táctica que Kasparov había utilizado contra oponentes humanos en el pasado.

Lo que sorprendió a Kasparov fue el movimiento posterior de Deep Blue. Kaspárov la calificó como «de tipo humano». John Nunn, el gran maestro de ajedrez inglés, la describió como «asombrosa» y «excepcional». La jugada dejó a Kasparov furioso y acabó por desbaratar su estrategia. Estaba tan perturbado que acabó abandonando, perdiendo la partida. Peor aún, nunca se recuperó, haciendo tablas en las tres partidas siguientes y luego cometiendo el error que le llevó a la muerte en la partida final.

La jugada se basaba en la ventaja estratégica que puede obtener un jugador al crear una fila abierta, una columna de casillas en el tablero (vista desde arriba) que no contiene piezas. Esto puede crear una ruta de ataque, normalmente para torres o reinas, libre de peones que bloqueen el camino. Durante el entrenamiento con el gran maestro Joel Benjamin, el equipo de Deep Blue aprendió que a veces había una opción más estratégica que abrir una fila y mover una torre hacia ella. En su lugar, la táctica consistía en apilar piezas en el archivo y luego elegir cuándo abrirlo.

Cuando los programadores aprendieron esto, reescribieron el código de Deep Blue para incorporar los movimientos. Durante la partida, el ordenador utilizó la posición de tener un archivo potencialmente abierto para presionar a Kasparov y obligarle a defenderse en cada movimiento. Esa ventaja psicológica acabó desgastando a Kasparov.

Desde el momento en que Kaspárov perdió, comenzaron las especulaciones y las teorías conspirativas. Los conspiranoicos afirmaron que IBM había utilizado la intervención humana durante la partida. IBM lo negó, afirmando que, de acuerdo con las reglas, la única intervención humana se produjo entre partidas para rectificar errores que se habían detectado durante el juego. También rechazó la afirmación de que la programación se había adaptado al estilo de juego de Kasparov. En su lugar, habían confiado en la capacidad del ordenador para buscar entre un enorme número de jugadas posibles.

La negativa de IBM a la petición de Kasparov de una revancha y el posterior desmantelamiento de Deep Blue no contribuyeron a acallar las sospechas. IBM también retrasó la publicación de los registros detallados del ordenador, como también había solicitado Kasparov, hasta después del desmantelamiento. Pero el posterior análisis detallado de los registros ha añadido nuevas dimensiones a la historia, incluyendo la comprensión de que Deep Blue cometió varios errores importantes.

Desde entonces se ha especulado con que Deep Blue sólo triunfó por un error en el código durante la primera partida. Uno de los diseñadores de Deep Blue ha dicho que cuando un fallo impidió que el ordenador seleccionara una de las jugadas que había analizado, en su lugar hizo una jugada al azar que Kasparov interpretó erróneamente como una estrategia más profunda.

Logró ganar la partida y el fallo se solucionó para la segunda ronda. Pero, supuestamente, el campeón del mundo estaba tan conmocionado por lo que consideraba la inteligencia superior de la máquina que no pudo recuperar la compostura y jugó con demasiada cautela a partir de entonces. Incluso perdió la oportunidad de remontar la táctica del archivo abierto cuando Deep Blue cometió un «terrible error».

Cualquiera de estas versiones de las reacciones de Kasparov a la partida sea cierta, apuntan al hecho de que su derrota se debió, al menos en parte, a las debilidades de la naturaleza humana. Pensó demasiado en algunas de las jugadas de la máquina y se preocupó innecesariamente por sus capacidades, cometiendo errores que finalmente le llevaron a la derrota. Deep Blue no poseía nada parecido a las técnicas de inteligencia artificial que hoy en día han ayudado a los ordenadores a ganar en juegos mucho más complejos, como el Go.

Pero incluso si Kasparov se sintió más intimidado de lo necesario, no se pueden negar los impresionantes logros del equipo que creó Deep Blue. Su capacidad para enfrentarse al mejor ajedrecista humano del mundo se basó en una increíble potencia de cálculo, que puso en marcha el programa de superordenadores de IBM que ha allanado el camino para algunas de las tecnologías de vanguardia disponibles en el mundo actual. Lo que hace que esto sea aún más asombroso es el hecho de que el proyecto no comenzó como un proyecto exuberante de uno de los mayores fabricantes de ordenadores, sino como una tesis de estudiante en la década de 1980.

Carrera de ajedrez

Cuando Feng-Hsiung Hsu llegó a Estados Unidos desde Taiwán en 1982, no puede haber imaginado que se convertiría en parte de una intensa rivalidad entre dos equipos que pasaron casi una década compitiendo por construir el mejor ordenador de ajedrez del mundo. Hsu había llegado a la Universidad Carnegie Mellon (CMU) de Pensilvania para estudiar el diseño de los circuitos integrados que componen los microchips, pero también tenía un antiguo interés por el ajedrez informático. Llamó la atención de los desarrolladores de Hitech, el ordenador que en 1988 se convertiría en el primero en vencer a un gran maestro del ajedrez, y le pidieron que colaborara en el diseño del hardware.

Pero Hsu pronto se enemistó con el equipo de Hitech tras descubrir lo que consideraba un fallo arquitectónico en su diseño propuesto. Junto con otros estudiantes de doctorado, comenzó a construir su propio ordenador, conocido como ChipTest, basándose en la arquitectura de la máquina de ajedrez del Laboratorio Bell, Belle. La tecnología personalizada de ChipTest utilizaba lo que se conoce como «integración a muy gran escala» para combinar miles de transistores en un solo chip, lo que permitía al ordenador buscar entre 500.000 jugadas de ajedrez cada segundo.

Aunque el equipo de Hitech llevaba ventaja, Hsu y sus colegas pronto les superarían con el sucesor de ChipTest. Deep Thought (llamado así por el ordenador de La guía del autoestopista galáctico, de Douglas Adams, construido para encontrar el sentido de la vida) combinaba dos de los procesadores personalizados de Hsu y podía analizar 720.000 jugadas por segundo. Esto le permitió ganar el Campeonato Mundial de Ajedrez por Ordenador de 1989 sin perder ni una sola partida.

Pero Deep Thought se topó con un obstáculo ese mismo año cuando se enfrentó (y perdió) al actual campeón mundial de ajedrez, un tal Garry Kasparov. Para vencer al mejor de la humanidad, Hsu y su equipo tendrían que ir mucho más allá. Ahora, sin embargo, contaban con el respaldo del gigante informático IBM.

Los ordenadores de ajedrez funcionan asignando un valor numérico a la posición de cada pieza en el tablero mediante una fórmula conocida como «función de evaluación». Estos valores pueden ser procesados y buscados para determinar la mejor jugada a realizar. Los primeros ordenadores de ajedrez, como Belle y Hitech, utilizaban múltiples chips personalizados para ejecutar las funciones de evaluación y luego combinar los resultados.

El problema era que la comunicación entre los chips era lenta y consumía mucha potencia de procesamiento. Lo que Hsu hizo con ChipTest fue rediseñar y reagrupar los procesadores en un único chip. Esto eliminó una serie de sobrecargas de procesamiento, como la comunicación fuera del chip, e hizo posible un enorme aumento de la velocidad de cálculo. Mientras que Deep Thought podía procesar 720.000 jugadas por segundo, Deep Blue utilizaba un gran número de procesadores que ejecutaban el mismo conjunto de cálculos de forma simultánea para analizar 100.000.000 de jugadas por segundo.

Aumentar el número de jugadas que el ordenador podía procesar era importante porque los ordenadores de ajedrez han utilizado tradicionalmente lo que se conoce como técnicas de «fuerza bruta». Los jugadores humanos aprenden de la experiencia pasada a descartar instantáneamente ciertas jugadas. Las máquinas de ajedrez, ciertamente en aquella época, no tenían esa capacidad y, en cambio, tenían que confiar en su capacidad para ver lo que podía ocurrir en cada jugada posible. Utilizaban la fuerza bruta para analizar un gran número de jugadas en lugar de centrarse en ciertos tipos de jugadas que ya sabían que tenían más probabilidades de funcionar. Aumentar el número de jugadas que una máquina podía analizar en un segundo le daba tiempo para mirar mucho más allá en el futuro, hacia dónde llevarían las diferentes jugadas a la partida.

En febrero de 1996, el equipo de IBM estaba listo para enfrentarse de nuevo a Kasparov, esta vez con Deep Blue. Aunque se convirtió en la primera máquina en derrotar a un campeón del mundo en una partida con controles de tiempo regulares, Deep Blue perdió la partida general por 4-2. Sus 100.000.000 de movimientos por segundo seguían sin ser suficientes para superar la capacidad humana de elaborar estrategias.

Para aumentar el número de movimientos, el equipo comenzó a mejorar la máquina explorando cómo podían optimizar un gran número de procesadores trabajando en paralelo, con gran éxito. La máquina final era un superordenador de 30 procesadores que, lo que es más importante, controlaba 480 circuitos integrados diseñados específicamente para jugar al ajedrez. Este diseño personalizado fue lo que permitió al equipo optimizar al máximo la potencia de cálculo en paralelo de los chips. El resultado fue una nueva versión de Deep Blue (a veces denominada Deeper Blue) capaz de buscar alrededor de 200.000.000 jugadas por segundo. Esto significaba que podía explorar cómo se desarrollaría cada estrategia posible hasta 40 o más movimientos en el futuro.

Revolución paralela

Para cuando la revancha tuvo lugar en Nueva York en mayo de 1997, la curiosidad del público era enorme. Los reporteros y las cámaras de televisión se arremolinaron en torno al tablero y se vieron recompensados con un reportaje cuando Kaspárov se marchó enfadado tras su derrota y gritó su falta en una rueda de prensa posterior. Pero la publicidad en torno a la partida también ayudó a establecer una mayor comprensión de lo lejos que habían llegado los ordenadores. Lo que la mayoría de la gente aún no sabía era cómo la tecnología detrás de Deep Blue ayudaría a extender la influencia de los ordenadores a casi todos los aspectos de la sociedad, transformando la forma en que utilizamos los datos.

Hoy en día se utilizan modelos informáticos complejos para respaldar los sistemas financieros de los bancos, para diseñar mejores coches y aviones, y para probar nuevos medicamentos. Los sistemas que extraen grandes conjuntos de datos (a menudo conocidos como «big data») para buscar patrones significativos intervienen en la planificación de servicios públicos como el transporte o la sanidad, y permiten a las empresas dirigir la publicidad a grupos específicos de personas.

Se trata de problemas muy complejos que requieren un procesamiento rápido de conjuntos de datos grandes y complejos. Deep Blue proporcionó a los científicos e ingenieros una importante visión de los sistemas multichip masivamente paralelos que han hecho esto posible. En concreto, mostraron las capacidades de un sistema informático de propósito general que controlaba un gran número de chips personalizados diseñados para una aplicación específica.

La ciencia de la dinámica molecular, por ejemplo, implica el estudio de los movimientos físicos de moléculas y átomos. Los diseños de chips personalizados han permitido a los ordenadores modelar la dinámica molecular para ver cómo podrían reaccionar los nuevos fármacos en el cuerpo, como si se tratara de una mirada anticipada a las diferentes jugadas de ajedrez. Las simulaciones de dinámica molecular han contribuido a acelerar el desarrollo de fármacos de éxito, como algunos de los utilizados para tratar el VIH.

Para aplicaciones muy amplias, como la modelización de sistemas financieros y la minería de datos, diseñar chips a medida para una tarea individual en estas áreas sería prohibitivo. Pero el proyecto Deep Blue ayudó a desarrollar las técnicas para codificar y gestionar sistemas altamente paralelizados que dividen un problema entre un gran número de procesadores.

Hoy en día, muchos sistemas para procesar grandes cantidades de datos dependen de unidades de procesamiento gráfico (GPU) en lugar de chips diseñados a medida. Éstas se diseñaron originalmente para producir imágenes en una pantalla, pero también manejan información utilizando muchos procesadores en paralelo. Por eso, ahora se utilizan a menudo en ordenadores de alto rendimiento que ejecutan grandes conjuntos de datos y para ejecutar potentes herramientas de inteligencia artificial como el asistente digital de Facebook. Hay similitudes evidentes con la arquitectura de Deep Blue: chips personalizados (construidos para gráficos) controlados por procesadores de propósito general para impulsar la eficiencia en cálculos complejos.

El mundo de las máquinas de ajedrez, mientras tanto, ha evolucionado desde la victoria de Deep Blue. A pesar de su experiencia con Deep Blue, Kasparov aceptó en 2003 enfrentarse a dos de las máquinas de ajedrez más destacadas, Deep Fritz y Deep Junior. Y en ambas ocasiones consiguió evitar una derrota, aunque siguió cometiendo errores que le obligaron a empatar. Sin embargo, ambas máquinas vencieron convincentemente a sus homólogos humanos en los Campeonatos Mundiales por Equipos Hombre-Máquina de 2004 y 2005.

Junior y Fritz marcaron un cambio en el enfoque del desarrollo de sistemas para el ajedrez por ordenador. Mientras que Deep Blue era un ordenador construido a medida que dependía de la fuerza bruta de sus procesadores para analizar millones de jugadas, estas nuevas máquinas de ajedrez eran programas de software que utilizaban técnicas de aprendizaje para minimizar las búsquedas necesarias. Esto puede vencer a las técnicas de fuerza bruta utilizando sólo un PC de sobremesa.

Pero a pesar de este avance, todavía no tenemos máquinas de ajedrez que se asemejen a la inteligencia humana en la forma de jugar el juego – no lo necesitan. Y, en todo caso, las victorias de Junior y Fritz refuerzan aún más la idea de que los jugadores humanos pierden ante los ordenadores, al menos en parte, por su humanidad. Los humanos cometieron errores, se pusieron nerviosos y temieron por su reputación. Las máquinas, en cambio, aplicaron implacablemente cálculos lógicos al juego en sus intentos por ganar. Algún día podríamos tener ordenadores que realmente reproduzcan el pensamiento humano, pero la historia de los últimos 20 años ha sido el auge de sistemas que son superiores precisamente porque son máquinas.